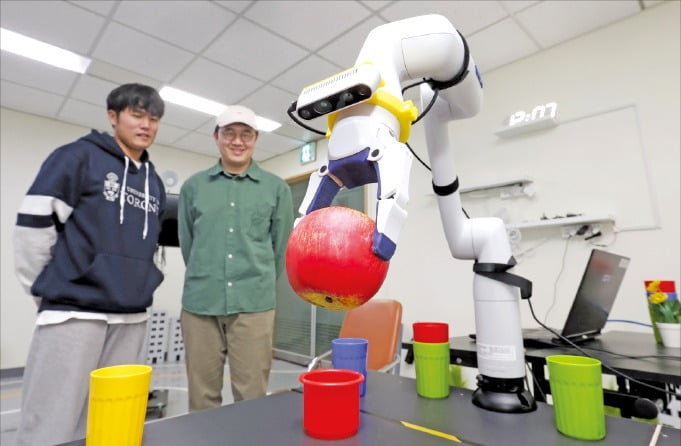

“사과를 집어서 파란 컵 위에 올려줘.” 말만 했을 뿐인데 로봇 팔이 움직였다. 노랑 초록 보라 등 색색의 컵 사이에서 사과를 집어 들더니 파란 컵에 정확히 올렸다. 장병탁 서울대 컴퓨터공학부 교수(AI연구원장) 연구팀이 개발한 ‘자기 주도 인공지능(AI)’ 로봇이다.

이 로봇은 사과처럼 둥근 물체를 들어 옮기고 컵에 올려놓는 작업의 프로그래밍을 받지 않았다. ‘사과’ ‘컵’ ‘파란색’이라고 사람이 이름표를 붙여준(라벨링) 사진 데이터를 학습한 적도 없다. 현실 세계에서 사과와 컵을 카메라 눈으로 살펴보고, 팔과 집게 손으로 만져보며 스스로 이 물건이 무엇이고 어떻게 다뤄야 하는지 ‘체득’했다.

김정현 씨(서울대 컴퓨터공학부 박사과정)는 “가령 ‘케이스에 들어있는 에어팟’처럼 로봇이 본 적 없고 기성 데이터를 찾기 어려운 물건이라도 한 번만 말로 가르쳐주면 스스로 파악하고 학습할 수 있다”고 설명했다. 연구팀은 사람의 발화 맥락까지 이해해 “배고프다”고 하면 여러 물체 중에서 먹을 것을 찾아 “바나나를 줄까요?”라고 물으며 건네는 AI 로봇 모델도 개발했다.

이런 AI 로봇은 AI에 ‘신체’를 부여하려는 시도의 산물이다. 실물 세계와 상호작용할 수 있는 신체가 없다는 건 현재 챗GPT류의 대규모언어모델(LLM) 기반 AI가 가진 가장 큰 한계다. 장 교수는 “챗GPT는 컴퓨터에서 배운 텍스트 데이터를 기반으로 그럴듯한 답을 내놓을 뿐”이라며 “때로 AI가 허구의 정보를 제공하는 환각 현상도 이 때문”이라고 했다.

그러면서 “AI가 정말로 똑똑해지고 쓸모가 있으려면 ‘체화된’ 지식을 기반으로 불확실한 세계에 적응하고 대처할 수 있어야 한다”고 강조했다. AI가 인간 수준으로 올라서려면 텍스트와 사진으로 이뤄진 가상 세계를 벗어나 현실에서 오감으로 지식을 습득해야 한다는 얘기다. 서울대 AI연구원은 이를 위해 ‘베이비마인드’ 프로젝트를 진행하고 있다. 언어 능력이 부족한 아기의 학습 방식을 모방해 AI가 원천적으로 개념을 형성하고 지능을 발달시키는 과정까지 구현하는 게 목표다. 이렇게 되면 변화무쌍한 현실에서 환경에 적응하고, 스스로 생각하며 행동하는 AI 로봇이 나올 수 있다.

AI의 발전이 모든 인간에게 장밋빛 미래는 아니다. 사람의 일자리가 줄어들고 물리적인 통제마저 어려워질 수 있다는 두려움도 커진다. 장 교수는 “적절한 제도와 규범이 필요하다”면서도 “AI 역시 인류가 발전시켜온 기술과 도구의 연장선일 뿐”이라고 했다. 그는 “AI만 발전하고 인간은 퇴화하는 게 아니라 두 존재가 함께 진화한다고 봐야 한다”며 “AI의 보조를 받는 인간은 새로운 능력을 더 발달시켜 새로운 종(種)으로 자리매김할 수 있다”고 강조했다.

빈난새 기자 binthere@hankyung.com

관련뉴스